Czy najnowsze modele sztucznej inteligencji naprawdę rozumują, czy tylko sprawiają takie wrażenie? Inżynierowie Apple postanowili to sprawdzić w badaniu zatytułowanym „Iluzja myślenia”. Wyniki okazały się zaskakujące – dzisiejsze zaawansowane modele językowe potrafią tworzyć pozory logicznego myślenia, ale szybko ujawniają swoje ograniczenia, gdy postawi się przed nimi naprawdę trudne problemy. To odkrycie ma istotne znaczenie dla użytkowników i przyszłego rozwoju AI, bo pokazuje, jak daleko obecne systemy są od prawdziwego zrozumienia.

Modele, które „myślą na głos”

W ostatnich latach duże modele językowe (LLM) nauczyły się nie tylko przewidywać kolejne słowa, ale także prezentować tok rozumowania przed udzieleniem odpowiedzi. Takie podejście – często nazywane „chain-of-thought” (łańcuchem myśli) – sprawia, że model myśli na głos, wypisując po kolei swoje założenia i kroki. Powstała wręcz nowa podkategoria systemów AI określanych jako Large Reasoning Models, czyli modele wyspecjalizowane w rozwiązywaniu zadań wymagających rozumowania. Przykładowo potrafią one rozwiązywać zadania matematyczne pokazując krok po kroku obliczenia albo analizować złożone problemy logiczne z komentarzem do każdej próby. Na papierze wygląda to imponująco – AI wydaje się naprawdę rozumować. Rzeczywiście, dodanie tego rodzaju „myślenia na głos” często poprawia wyniki na różnych benchmarkach matematycznych czy programistycznych.

Problem w tym, że dotychczasowe testy mogły nie do końca oddawać rzeczywiste zdolności rozumowania. Standardowe łamigłówki i zadania, na których sprawdzano AI, często są znane modelom z treningu (tzw. data contamination). Do tego skupiano się głównie na poprawności końcowej odpowiedzi, ignorując jakość samego rozumowania. W efekcie nie było jasne, czy modele faktycznie rozumieją zadanie, czy tylko dopasowują wzorce i dają poprawne wyniki tam, gdzie „widziano” coś podobnego wcześniej. Innymi słowy, czy model myśli, czy tylko udaje? To właśnie zjawisko badacze Apple nazwali „iluzją myślenia”.

Łamigłówki zamiast standardowych testów

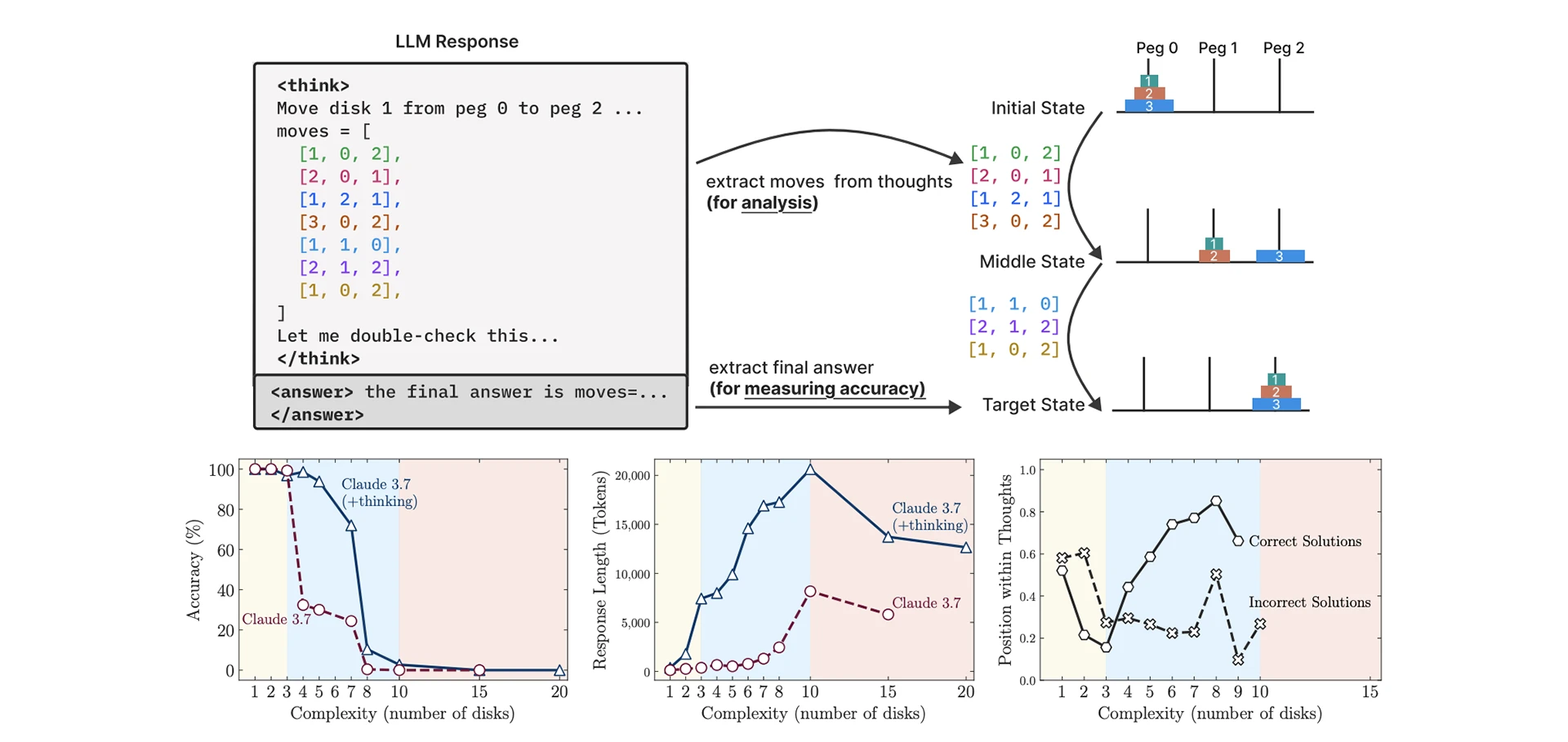

Aby rzetelnie zbadać zdolności rozumowania AI, zespół Apple stworzył zestaw kontrolowanych łamigłówek logicznych o różnej skali trudności. Każda łamigłówka miała proste, jasno zdefiniowane zasady i można było stopniowo zwiększać jej złożoność. Przykładem jest słynna Wieża z Hanoi – układanka polegająca na przekładaniu krążków, w której trudność rośnie wykładniczo wraz z liczbą krążków. Inne zagadki to m.in. klasyczna łamigłówka przeprawy przez rzekę (ang. River Crossing) czy układanie klocków na stosie (Blocks World). Takie podejście pozwoliło badaczom precyzyjnie sterować poziomem trudności zadania i obserwować, jak modele AI radzą sobie krok po kroku w trakcie rozwiązywania. Co ważne, dzięki symulatorom tych łamigłówek zespół Apple mógł sprawdzać każdą część toku rozumowania modelu – weryfikować każdy ruch i każdą propozycję rozwiązania na bieżąco. To coś więcej niż tylko ocena końcowego wyniku: pozwoliło zajrzeć do wnętrza „myśli” AI i zobaczyć, jak dokładnie model próbuje rozwiązać problem.

Tak przygotowane środowisko testowe eliminuje problemy typowe dla poprzednich metod. Po pierwsze, nowe zagadki nie były częścią danych treningowych, więc modele nie mogły ich wcześniej „wykuć na pamięć”. Po drugie, utrzymując spójne zasady logiki w danej łamigłówce i zwiększając stopniowo jej skalę (np. więcej krążków w Wieży z Hanoi, więcej elementów w innych zadaniach), badacze mogli sprawdzić granice możliwości modelu. Innymi słowy: od jakiego poziomu trudności sztuczna inteligencja kompletnie sobie nie radzi.

Trzy poziomy trudności – od prostych zadań po kryzys

Po serii eksperymentów z udziałem najnowocześniejszych modeli okazało się, że wydajność AI dzieli się wyraźnie na trzy regimy w zależności od złożoności problemu. Co więcej, wyniki te były zaskakujące nawet dla samych badaczy. Oto, co zaobserwowano:

Niska złożoność – paradoks nadmiernego kombinowania.

W prostych zadaniach standardowe modele językowe (te, które nie „myślą na głos”) radziły sobie lepiej niż ich rozszerzone, rozumujące wersje. Brzmi to paradoksalnie, ale modele z włączonym rozumowaniem często przekombinowywały. Gdy problem był łatwy, poprawne rozwiązanie pojawiało się szybko, lecz „myślący” model zamiast zakończyć, brnął dalej generując kolejne kroki i w rezultacie potrafił się pogubić. To trochę tak, jakby ktoś znał odpowiedź na proste pytanie, ale na siłę doszukiwał się drugiego dna – i ostatecznie udzielił błędnej odpowiedzi przez nadmierne analizowanie.

Średnia złożoność – myślenie popłaca.

Przy zadaniach o umiarkowanym poziomie trudności dodatkowy tok rozumowania okazał się przydatny. Modele „myślące” zaczynały wtedy wygrywać z modelami standardowymi. Mogły poświęcić więcej kroków na analizę, co pozwalało im korygować błędy i wybierać właściwe podejście, zanim podały ostateczną odpowiedź. Ten wynik pokazał potencjał drzemiący w mechanizmach samokontroli i analizowania własnych rozwiązań – w takich warunkach AI faktycznie działa bardziej jak rozwiązujący łamigłówki niż tylko generator tekstu.

Wysoka złożoność – uniwersalna katastrofa.

Gdy poziom trudności przekroczył pewien krytyczny próg, wszystkie modele całkowicie zawiodły – niezależnie od tego, czy „myślały na głos”, czy nie. To jednak nie koniec niespodzianek. Okazało się, że modele rozszerzone o mechanizmy rozumowania w obliczu bardzo trudnych zadań… zaczynały myśleć mniej. Mimo że mogły jeszcze kontynuować analizę (miały dostępny odpowiedni budżet tokenów, czyli kolejnych kroków rozumowania), przestawały z niego w pełni korzystać. Innymi słowy, kiedy problem robił się zbyt trudny, AI szybko poddawała się i udzielała krótkiej, często błędnej odpowiedzi, zamiast próbować do końca. To tak, jakby komputerowy „myśliciel” tracił zapał dokładnie wtedy, gdy najbardziej potrzeba intensywnego wysiłku.

Wyniki eksperymentów jasno pokazały, że przy pewnym poziomie złożoności następuje załamanie – skuteczność modeli spada praktycznie do zera. Co ważne, nie jest to powolny spadek, lecz gwałtowny klif wydajności. Fakt, że modele redukują wysiłek myślowy dokładnie w momencie osiągnięcia tego klifu, sugeruje poważne ograniczenia obecnych architektur AI. Mimo ogromnej mocy obliczeniowej i sprytnych sztuczek (jak wspomniane „myślenie na głos” czy mechanizmy samokontroli), modele te wciąż nie potrafią rozwiązywać naprawdę złożonych problemów w sposób zbliżony do ludzkiego.

Zaskakujące odkrycia: gdy AI nie umie skorzystać z podpowiedzi

Najbardziej ciekawy przykład iluzji myślenia wyszedł jednak na jaw, gdy badacze podjęli próbę „pomocy” modelom. Co jeśli AI dostanie gotowy przepis na rozwiązanie? – to pytanie zadali sobie autorzy badania. W ramach testu podsunęli modelom jawny algorytm rozwiązania jednej z łamigłówek, a konkretnie Wieży z Hanoi. Innymi słowy, dano AI instrukcję krok po kroku, jak przenosić krążki, by osiągnąć cel. Wystarczyło, by model sumiennie wykonał te instrukcje. Wynik? Bez zmian. Modele nadal sobie nie radziły z trudniejszymi wersjami zadania. Nawet mając rozwiązanie podane na tacy, sztuczna inteligencja gubiła się, gdy tylko problem stawał się wystarczająco złożony.

To odkrycie ma poważne implikacje. Oznacza bowiem, że modele AI nie potrafią pewnie realizować nawet jasno zdefiniowanych instrukcji, jeśli przekraczają one pewien poziom skomplikowania. Zawodzą nie dlatego, że nie wymyśliły rozwiązania, ale dlatego, że nie umieją go konsekwentnie zastosować. Można powiedzieć, że w takich sytuacjach obecne AI tracą cechę, którą uważamy za istotę rozumowania – zdolność niewzruszonego podążania za logiką aż do końca zadania.

Co więcej, analiza poszczególnych łamigłówek ujawniła brak spójności w rozumowaniu modeli. Przykładowo, ten sam model potrafił wykonać nawet 100 poprawnych ruchów w złożonej wersji Wieży z Hanoi, a zarazem pomylić się już po 5 ruchach w innej łamigłówce (zagadce przeprawy przez rzekę). Oznacza to, że sukces AI w jednym typie zadania nie gwarantuje sukcesu w innym – nawet jeśli oba wymagają podobnego myślenia logicznego. Modele nie generalizują dobrze strategii rozwiązywania problemów, lecz uczą się ich w sposób fragmentaryczny. To kolejny przejaw iluzoryczności ich „myślenia”.

Dlaczego to badanie jest ważne?

Wnioski z projektu „Iluzja myślenia” są istotne zarówno dla twórców technologii AI, jak i dla zwykłych użytkowników. Po pierwsze, obalają nadmierny optymizm co do obecnych możliwości sztucznej inteligencji. Okazuje się, że choć nowoczesne modele potrafią zachwycać umiejętnością rozwiązywania niektórych zadań, wcale nie są uniwersalnymi myślicielami. Gdy postawimy przed nimi problem wymagający wielu kroków rozumowania lub precyzyjnego planowania, prędzej czy później natrafimy na „ścianę”, za którą model po prostu przestaje sobie radzić. Co gorsza, może on wtedy nadal generować odpowiedzi brzmiące bardzo przekonująco, choć całkowicie błędne. Dla użytkownika niespecjalizującego się w AI to pułapka – łatwo uwierzyć w rozbudowane wyjaśnienia podsuwane przez model, nawet jeśli są iluzją prawdziwego rozumowania.

Z punktu widzenia programistów i firm wdrażających AI, badanie Apple stanowi cenną wskazówkę, gdzie przebiegają granice zastosowań takich modeli. Jeśli planujemy użyć AI do zadań wymagających niezawodnego rozumowania (np. asystent do doradzania w skomplikowanych kwestiach finansowych czy medycznych), musimy pamiętać, że obecne modele mogą zawodzić w nieprzewidywalny sposób. Proste problemy wcale nie potrzebują „rozumującej” AI – zwykły model poradzi sobie szybciej i często trafniej. Złożone problemy z kolei mogą przerosnąć nawet najlepsze dzisiejsze modele, więc kluczowe jest testowanie ich na odpowiednim poziomie trudności przed wdrożeniem. Apple sugeruje, by znaleźć ten „punkt krytyczny” dla danego modelu zawczasu, bo załamanie wydajności nie daje o sobie znać stopniowo – następuje nagle.